Davide Bruno. Walking City a Realtà aumentata

|

Durante il periodo a cavallo tra la fine degli anni Sessanta e la fine del decennio successivo, in parallelo con le missioni lunari del programma Apollo, il design degli oggetti e degli spazi si è cimentato con dinamiche visioni di futuro. Osservati a distanza di mezzo secolo, i mondi allora immaginati dalle avanguardie storiche paiono le premesse di progetti e soluzioni tecnologiche che rivelano oggi nuove e sorprendenti possibilità applicative. Sperimentazioni o prodotti che possiedono già un impatto rilevante nella società, spesso in sostegno a pratiche specialistiche che quasi metaforicamente avvengono negli interni del corpo o degli involucri abitati, piuttosto che nei grandi spazi aperti del cosmo. Ancora poco diffusa nei costumi e negli usi quotidiani (dopo l’anticipatorio tentativo della prima generazione dei Google Glasses), la Realtà Aumentata si sta infatti diffondendo negli ultimi anni in settori specialistici come la medicina chirurgica, ma anche la mobilità o la pianificazione urbana.

Il visore Hololens di Microsoft, utilizzato nella chirurgia del progetto Azure di Philips Le ultime generazioni di interfaccia AR permettono di sovrapporre alla vista del corpo fisico del paziente immagini virtuali a elevata definizione, fornendo ai chirurghi durante gli interventi una visione simile percettivamente a quella dei “raggi X”. Le applicazioni in questo campo si concentrano sui visori Mixed Reality. Tra questi, il modello Hololens sviluppato da Microsoft e giunto alla seconda serie: un occhiale dotato di sensori e hardware miniaturizzato (processori, telecamere e obiettivi di proiezione). La visiera, in grado di visualizzare nella metà inferiore della lente immagini tridimensionali calibrate in base alla distanza interpupillare (IPD), si presta da supporto a operazioni chirurgiche complesse, come quelle svolte nelle sale operatorie ibride del progetto Azure di Philips. La visualizzazione Mixed Reality, integrata a sistemi di imaging e monitoraggio in “presa diretta” consente alle equipe mediche di effettuare interventi maggiormente mirati ed efficaci. Similmente, il service-design applicato dai sistemi software elaborati dalla start-up californiana EchoPixel, fondata da Sergio Aguirre, si basa su modelli visivi generati su base di diagnostica per immagini live. Nello specifico, il sistema sviluppa soluzioni di imaging 3D ricavati da fonti bidimensionali, generando “ologrammi” visibili solo all’utente che, integrati da una apposita segnaletica, possono consentirgli di “muoversi” con maggiore consapevolezza all’interno del corpo umano. La tecnologia in Mixed Reality costituisce oggi la base di ricerca per soluzioni come il Robotic Surgery, l’Image Guided Surgery, la tecnica Fusion, il Bio-Hacking.

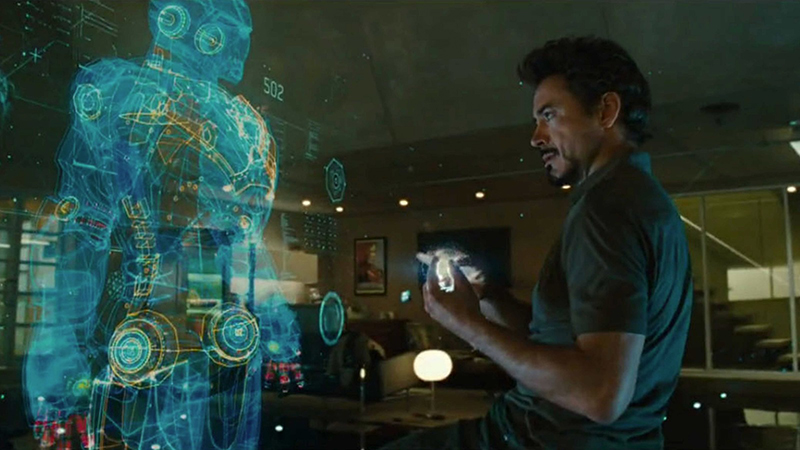

Un’operazione chirurgica a “ologramma” attraverso il sistema EchoPixel Oltre alle visioni anticipatrici delle avanguardie, la capacità di operare tramite interfacce o programmi robotici, senza affidarsi alla vista diretta, può richiamare immaginari della fantascienza recente, che tanto impatto hanno avuto sulla cultura postmoderna. Pare per esempio direttamente mutuata da un film Marvel la tecnologia di guida a Realtà Aumentata adottata per i jet Eurofighter Typhoon. In questo caso, i caschi dei piloti sono implementati da un sistema di riconoscimento visivo con cui è possibile interfacciarsi anche tramite controllo vocale. Intrecciandosi con le informazioni fornite in tempo reale da una banca dati esterna, controllato da intelligenza artificiale, i caschi restituiscono ai piloti un’esperienza di ingaggio del tutto simile a quella visualizzata da Iron Man, in un film recente ma ormai già non più di fantascienza. Analogamente, l’ultima generazione di caschi per i caccia F35 adotta visiere collegate a sei telecamere poste sulla fusoliera, che permettono di eliminare visivamente i vincoli fisici dell’aereo stesso: ruotando per esempio la testa, il pilota non vede il sedile alle sue spalle, ma il cielo attorno.

Il sistema di realtà mista sviluppato dall’azienda Svizzera WayRay

Lo Space Planning laboratori del MIT: realtà mista e mattoncini LEGO Al di là del loro uso specifico, tali tecnologie si pongono nella scia di soluzioni sviluppate in ambito militare da cui poi sono derivate progetti innovativi per la vita quotidiana. Da simili dispositivi derivano già, infatti, diversi accessori per la mobilità applicabili a forme di trasporto leggero e a piattaforme self-driving car e di sharing mobility. Dai primi dispositivi di lettura della segnaletica stradale montati di serie sulle vetture Opel Insigna Serie A, agli sviluppi del sistema Autopilot di Tesla, si passa oggi a progetti come lo schermo olografico Navion, sviluppato dall’azienda Svizzera WayRay, già testato e lanciato sul mercato. Integrabile nel parabrezza, Navion integra sistemi di tracing e mappatura, supportati da intelligenze artificiali, che amplificano la percezione dei segnali e mutano completamente l’esperienza di guida e la sicurezza su strada. Al di là degli specifici scenari delineabili, tali soluzioni offrono esempi delle dinamiche percettive che il design quasi immateriale della Realtà Aumentata traccia già nel mondo tangibile dei corpi e delle città. La walking city oggi parte dagli occhi, e vede in AR. 15.12.19 Davide Maria Bruno (Milano ’63), professore associato al Politecnico di Milano, architetto e design Ph.D. Delegato della Scuola del Design per i Concorsi e lo Sviluppo di Innovazione e Creatività per le Imprese. Compasso d’oro nell’ambito del progetto universitario “Agenzia SDI” (Sistema Design Italia) del Politecnico di Milano. |

Robert Downey Jr nel ruolo di Tony Stark/Iron Man

Robert Downey Jr nel ruolo di Tony Stark/Iron Man